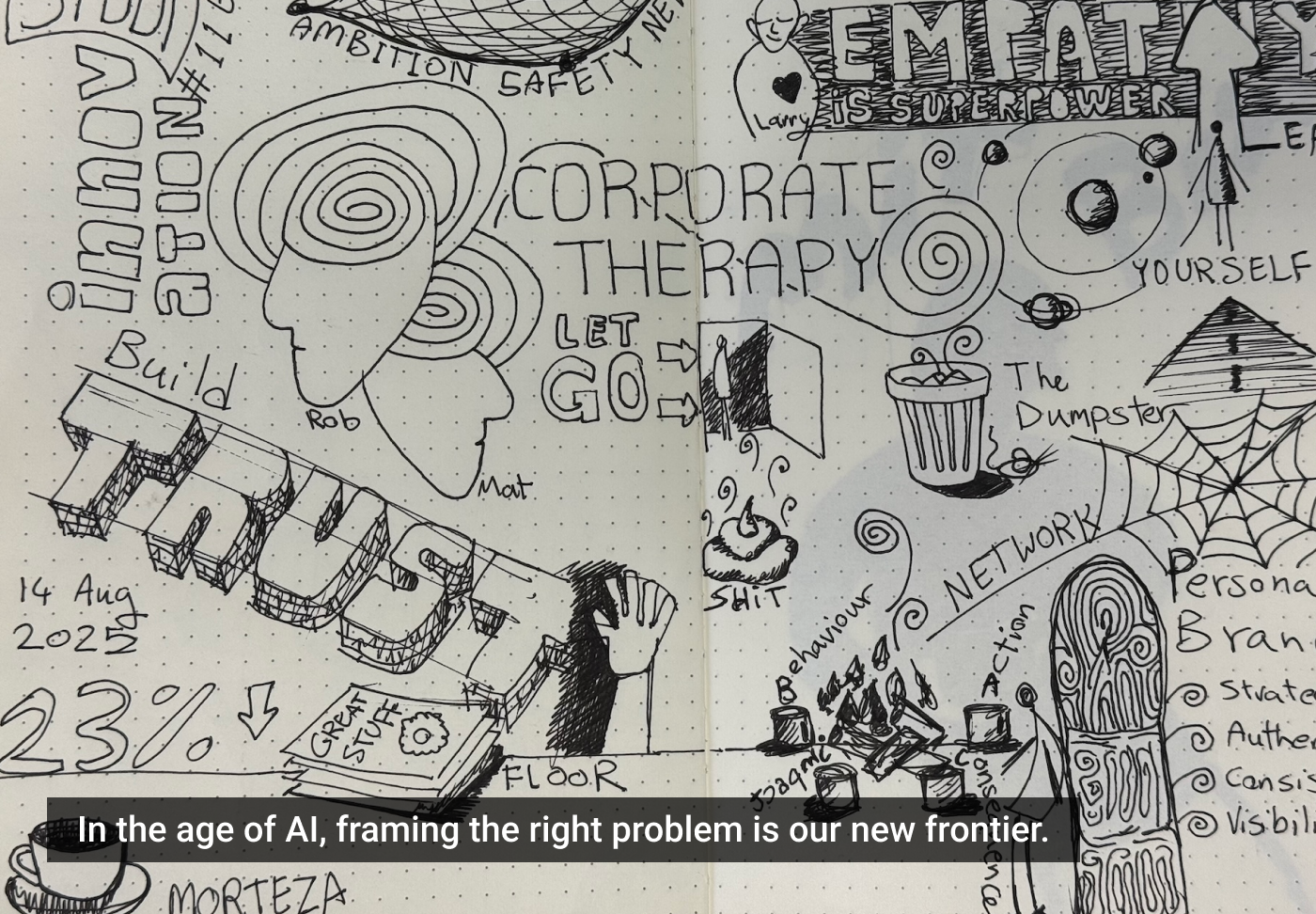

A/B Tests: O Mito do Design Orientado por Dados

Descubra por que os testes A/B podem não ser tão confiáveis quanto parecem e como eles podem enganar decisões de design.

O teste A/B é considerado a ferramenta definitiva no design orientado por dados. Modifique a cor de um botão, ajuste uma manchete e deixe os números mostrarem o caminho.

Mas e se o seu teste A/B for apenas um jogo de adivinhação disfarçado? E se adicionar mais variações com testes A/B/C/D apenas piorar o problema?

A Falsa Promessa da Significância Estatística

Testes A/B assumem um ambiente controlado, mas a web é tudo menos controlada. Eles são influenciados por tendências sazonais, mudanças de estratégia de concorrentes, alterações em algoritmos de anúncios e atualizações imprevisíveis do Google.

Os designers se apegam aos testes A/B porque parecem científicos. Um intervalo de confiança e um valor p dão a ilusão de certeza. No entanto, significância estatística não significa o que muitos pensam. Um nível de confiança de 95% não significa que a variação vencedora está correta 95% das vezes.

O Problema dos Pequenos Tamanhos de Amostra

A maioria dos testes A/B não tem poder suficiente por falta de tráfego para gerar resultados significativos. Sem milhares de conversões por variante, os dados são pouco confiáveis. Empresas como Google e Amazon tiram insights desses testes, enquanto empresas menores perseguem fantasmas estatísticos.

Teste A/B/C/D: Mais Variantes, Mais Problemas

Testar mais variantes ao mesmo tempo amplifica o problema. Quanto mais variações testadas, maior a chance de resultados falsos positivos. Além disso, raramente se consideram efeitos de interação. Um botão verde pode superar um vermelho em um teste de variável única, mas essa diferença pode mudar com outro layout ou manchete.

O Custo Oculto do Excesso de Testes

Testar tudo tem um preço oculto: fadiga de decisão. Obsessão por micro-otimizações leva a uma perda de tempo em melhorias incrementais, em vez de decisões de design estratégicas e ousadas. Empresas líderes investem em melhores produtos, não apenas designs melhor testados.

Quando o Teste A/B Faz Sentido

Testes A/B são úteis quando o tráfego é suficiente para suportar resultados estatisticamente significativos. Testes são valiosos ao avaliar grandes decisões de design, como estruturas de preços, layouts de página ou estratégias de mensagens, e só funcionam se conduzidos por tempo suficiente.

O Que Fazer em Vez de Confiar Cegamente no A/B Testing

Em vez de focar em testes divididos, equipes devem buscar insights reais dos usuários, como análise de mapas de calor e gravações de sessões. Experimentos longitudinais fornecem uma visão mais clara de tendências de longo prazo. Modelos comportamentais gerados por IA podem simular interações em grande escala.

O Teste A/B Não Vai Te Salvar

O teste A/B, quando feito corretamente, é uma ferramenta poderosa para refinar ideias, mas não as cria. Nenhum teste de divisão salvará um produto ruim ou corrigirá uma experiência defeituosa. Em vez de deixar os dados te levarem em círculos, ouça seus usuários, tome riscos ousados e teste quando realmente importar.