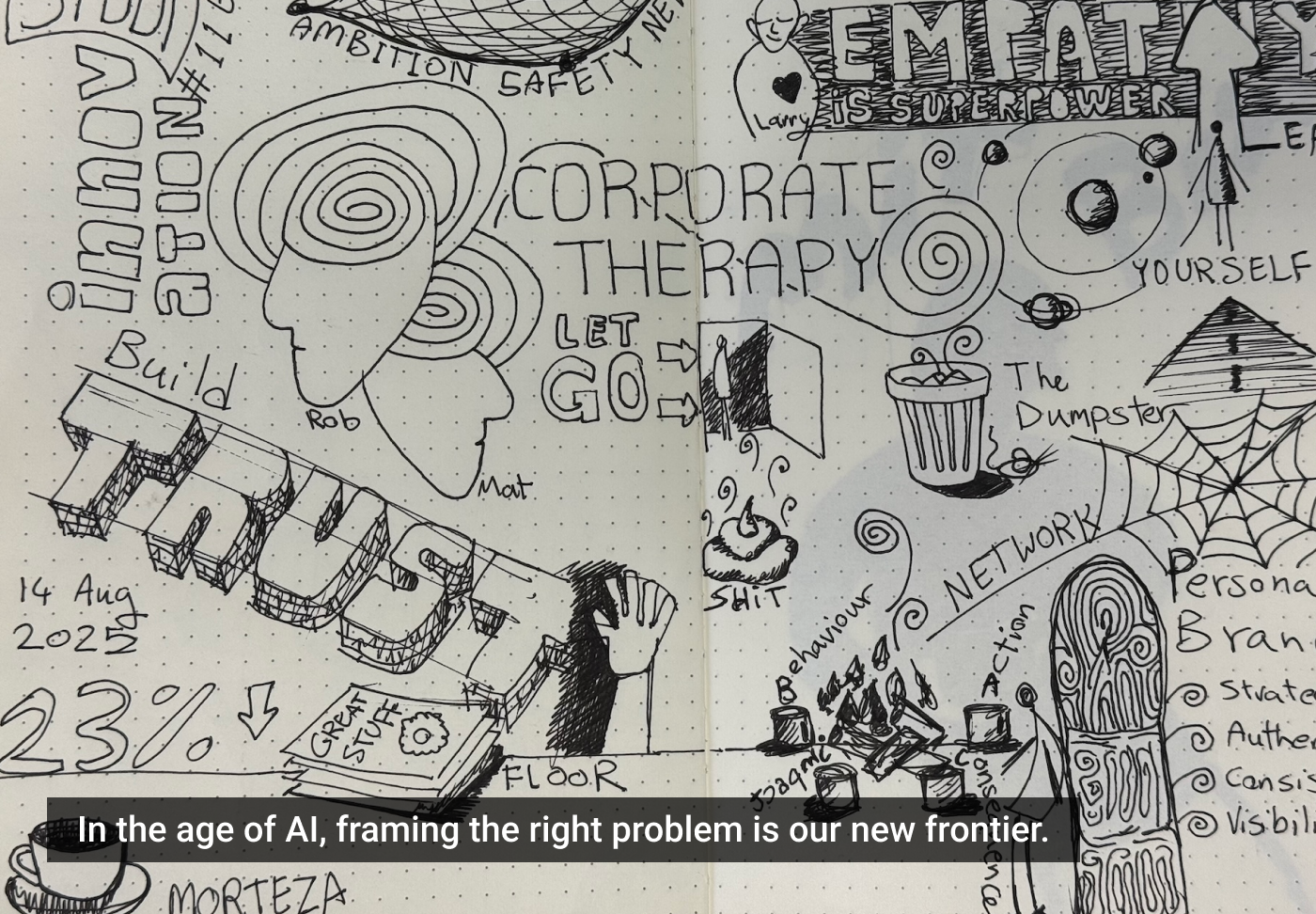

Como a mentalidade errada prejudica a IA

Descubra como a abordagem inadequada pode limitar o potencial da inteligência artificial nas organizações.

A mentalidade de ‘martelo’ subestima o potencial da inteligência artificial (IA), segundo um estrategista de UX/IA que, em 2024, foi contratado por uma empresa farmacêutica da Fortune 150. Durante uma apresentação, ele propôs o desenvolvimento de ‘AGI Organizacional’ — sistemas de IA que entendem o contexto, a cultura e os objetivos dos usuários. No entanto, um VP interrompeu, afirmando que a IA é apenas um martelo em busca de um prego, refletindo uma abordagem errada no setor.

Sete padrões e o gap de orquestração

O Project Management Institute identifica 7 padrões de IA: hiperpersonalização, sistemas autônomos, análise preditiva e decisões, interações humanas, padrões e anomalias, reconhecimento e sistemas orientados por metas. Com o surgimento do ChatGPT, o padrão de conversação integrou-se a outros, criando novas possibilidades e desafios de fragmentação.

Evidências do desafio:

- 80% de falha em projetos de IA

- 70% das falhas devido a lacunas de processos/pessoas

- 42% dos projetos são abandonados no meio do caminho

Esse caos é previsível e necessário, refletindo o ciclo de ‘hype’ da Gartner, que passa por fases de emergência, experimentação, desilusão, iluminação e produtividade.

A visão sistemática de Turing

Alan Turing, pioneiro da ciência da computação, imaginou máquinas inteligentes com base em quebra-cabeças linguísticos. Sua abordagem sistemática incluía definir resultados, métodos de avaliação e soluções de engenharia. Hoje, a IA conversacional transforma nossa interação com outras capacidades de IA.

A renascença digital de Babel

A orquestração sistemática enfrenta desafios semelhantes à história da Torre de Babel, onde falhas de comunicação prevalecem. Modelos de linguagem podem ajudar a superar essas lacunas, mas é necessário projetar sistemas que considerem todo o espectro da comunicação humana.

Projetando a orquestra invisível

O livro de Robb Wilson e Josh Tyson, “Age of Invisible Machines“, destaca a necessidade de ecossistemas de orquestração, onde múltiplos agentes de IA trabalham juntos de forma integrada. Seus princípios incluem definir resultados antes dos outputs, preservar o contexto e emergir de forma ética.

Estamos nos aproximando de um ponto de transição, onde as práticas recomendadas emergem e a implementação sistemática se torna possível. A questão não é se a IA transformará a experiência humana, mas sim se abordaremos essa transformação com intencionalidade e sabedoria.

Imagem em destaque: Yves Binda.