Roteamento de IA: Apps mais inteligentes com SDK

Aprenda a usar o roteamento de modelos sensível ao ambiente para criar apps de IA mais eficientes com o AI SDK.

Se você está desenvolvendo aplicações de IA, provavelmente está lidando com mais de um modelo de linguagem em sua aplicação: GPT-4 para tarefas gerais, Claude para codificação ou até mesmo o mais recente Nano Banana para geração de imagens. Durante o desenvolvimento, você pode querer experimentar modelos de código aberto localmente, caso seu hardware suporte.

No entanto, definir manualmente cada instância de modelo em toda a sua aplicação pode rapidamente tornar seu código desorganizado. E quando chega a hora de implantar em produção e usar modelos de última geração na nuvem, a última coisa que você gostaria é reescrever metade do seu código.

Neste artigo, mostramos um padrão útil para rotear chamadas de LLM de maneira “sensível ao ambiente”, usando o middleware do AI SDK. A ideia é simples: o ambiente da aplicação (dev ou prod) decide se as consultas LLM são enviadas para um modelo local (como Llama 3.2) ou um modelo de produção (GPT-5).

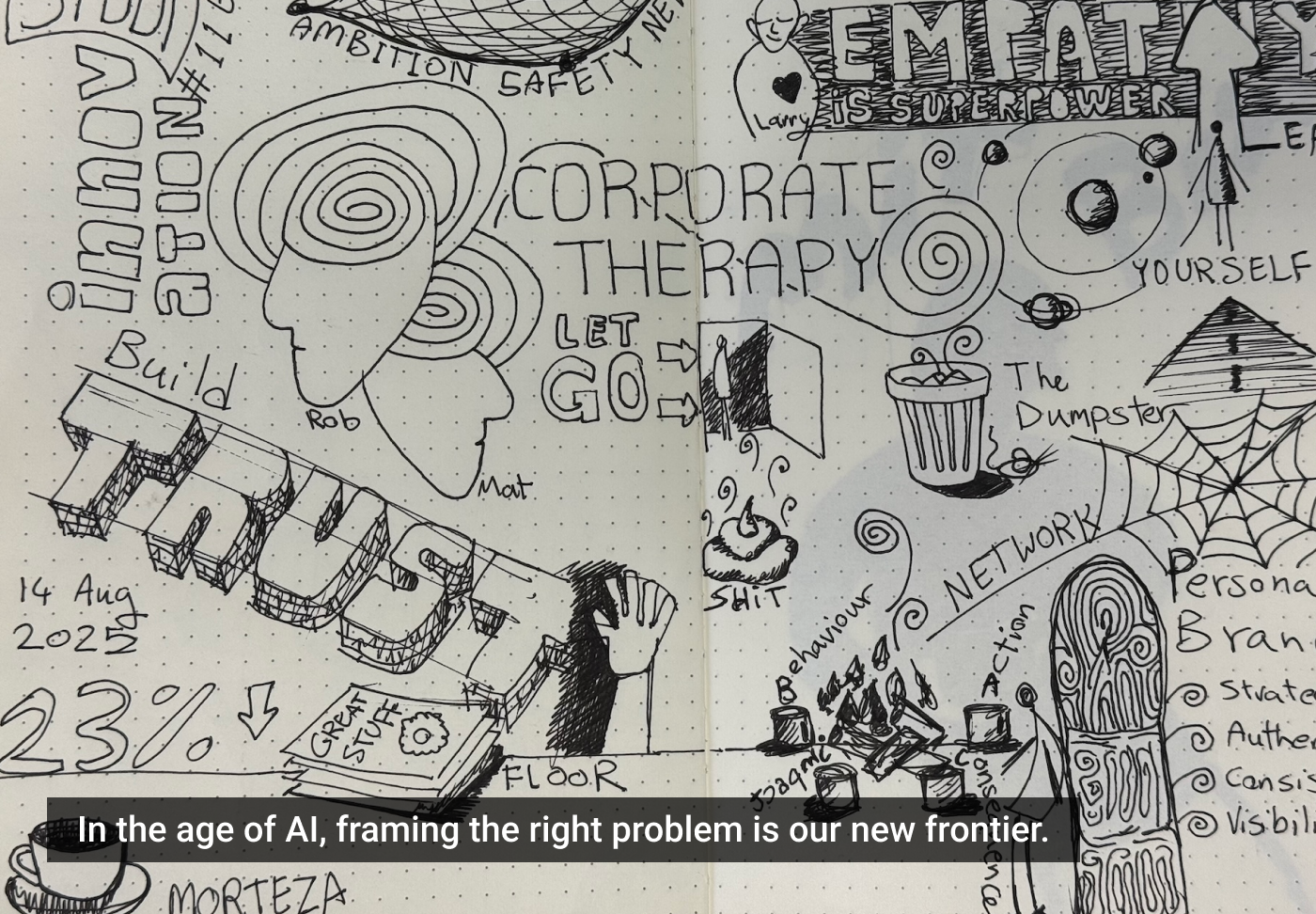

Ao final, teremos uma aplicação de chatbot simples com roteamento de modelo sensível ao ambiente para cada solicitação ao LLM:

O roteamento sensível ao ambiente oferece várias vantagens, como a gestão consistente de configuração, flexibilidade para experimentação e redução de custos, além de privacidade. Executar modelos localmente pode ajudar a reduzir custos e é mais privado, pois suas conversas não são armazenadas em um banco de dados na nuvem. Isso é especialmente útil durante o desenvolvimento, já que você não quer gastar o orçamento do modelo de produção enquanto depura.

Para começar, vamos configurar um modelo local usando o Ollama, uma ferramenta para baixar e executar modelos de linguagem de código aberto localmente em seu computador. Funciona em Windows, macOS e Linux. Você pode até criar sua própria versão local do ChatGPT.

Após configurar o Ollama, é hora de integrar o AI SDK com Next.js. Vamos criar um novo projeto Next.js e integrar o AI SDK. O AI SDK é um framework de agente TypeScript que torna o trabalho com diferentes modelos de linguagem consistente, independentemente de serem modelos na nuvem ou locais.

Vamos configurar o middleware do AI SDK, criando um arquivo que inicializa tanto modelos locais quanto de produção. O middleware intercepta e modifica solicitações antes de serem executadas, permitindo centralizar toda a lógica de roteamento de modelos em arquivos dedicados.

Finalmente, com o modelo pronto, criamos uma rota de API para lidar com mensagens de chat. A interface de chat se mantém inalterada, apenas o middleware lida com as diferenças entre os modelos locais e na nuvem.

Esse padrão de arquitetura flexível separa preocupações de forma clara e escala conforme suas necessidades. À medida que você desenvolve mais recursos baseados em IA, esse padrão sensível ao ambiente se torna uma base sólida para construir. As tecnologias de IA evoluem rapidamente, mas bons padrões arquiteturais são atemporais.